所谓的爬行和抓取,是搜索引擎工作的第一步。搜索引擎要向用户提供信息,自己的数据库里面就必须有庞大的数据量。所以,在网络上搜寻有一定质量的内容放入自己数据库是很重要的事情。

搜索引擎用来爬行和访问页面的程序被称为蜘蛛(spider)。

1,robots协议

蜘蛛访问网站页面时,类似用户访问。不同的是,蜘蛛在访问一个网站的时候,都会先访问网站根目录下的robots.txt文件。这个文件是网站和搜索引擎的一个协议,蜘蛛会遵守协议,不抓取被禁止的网址。

2,各搜索引擎蜘蛛

从访问日志当中,可以看到各搜索引擎的蜘蛛命名方式不一样:

Baiduspider百度蜘蛛

360spider 360蜘蛛

熟悉各家蜘蛛的名称,对后期优化中,分析爬行日志有很大作用。

3

爬行原则

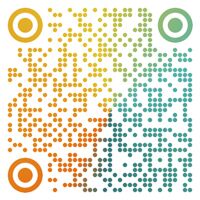

蜘蛛爬行有两种原则:广度原则和深度原则。如下图:

蜘蛛爬行有两种原则:广度原则和深度原则

深度原则的爬行方式:A-B-D-C-E-F

广度原则的爬行方式:A-B-C-D-E-F

两种方式各有优劣势,分别影响的是爬行网站数量多少和内页内容深度。

从理论上说,不管是深度优先还是广度优先,只要时间够,蜘蛛都能爬整个网络。但是在实际情况下,由于资源、时间的限制,搜索引擎需要一个科学的爬行规则。

所以搜索引擎往往是深度、广度通常是混合使用的,这样既客户照顾尽量多的网站,也能增加网站内页收录。